「AI秘籍」系列课程:

Interpretability 模型和 Explainability 模型之间的区别以及为什么它可能不那么重要

当你第一次深入可解释机器学习领域时,你会注意到类似的术语随处可见。Interpretability 与Explainability。解释与说明。我们甚至无法决定该领域的名称——是可解释机器学习 (interpretable machine learning - IML) 还是可解释人工智能 (explainable AI - XAI)?

我们将讨论一个定义,并希望澄清一些事情。这就是 Interpretability 模型和 Explainability 模型之间的区别。不过,我们应该警告你……

没有共性!

部分问题在于 IML 是一个新领域。定义仍在提出和争论中。机器学习研究人员也很快为已经存在的概念创造新术语。因此,我们将重点关注一个潜在的定义 1。

Interpretability 与机器学习模型将原因和结果练习起来的准确性有关,指在机器学习中可以观察到系统中因果关系(先验推导)的程度。

Explainability 与隐藏在深层网络中的参数证明结果的能力有关,是指机器学习的内部机制可以用人类语言解释(后验解释)的程度。

具体来说,我们将:

- 了解如何将模型分类为 interpretable 或者 explainable。

- 讨论 interpretability 的概念及其与此定义的关系

- 了解该定义的问题以及为什么可能没有必要使用它来对模型进行分类

Interpretable 机器学习

如果某事物能够被理解,我们就说它是可解释的。考虑到这一点,如果一个模型能够被人类自己理解,我们就说它是可解释的。我们可以查看模型参数或模型摘要,并准确了解预测是如何做出的。这类模型的另一个术语是intrinsically interpretable model(本质上可解释的模型)2。

Interpretable 模型可以被人类理解,无需任何其他辅助/技术。

决策树是此类模型的一个很好的例子。图 1给出了一棵经过训练的树,用于预测某人是否会拖欠(是)或不会拖欠(否)汽车贷款。要了解如何做出预测,我们只需遍历树的节点即可。

例如,假设一名29 岁、月收入3000 美元的女子提出申请。我们想了解为什么她会通过基于此模型的自动承保系统获得贷款。此人超过25 岁,所以我们直接进入第一个节点。然后,她的收入≥2000,所以我们再次直接进入 “No” 叶节点。换句话说,该模型预测该学生不会违约,贷款将获得批准。

假设我们还想要一个模型来预测一个人的最大贷款额度(Y)。我们使用一个人的年龄和收入作为特征。使用线性回归,我们得到以下等式:

Y = 100 × a g e + 10 × i n c o m e + 200 Y = 100 \times age + 10 \times income + 200 Y=100×age+10×income+200

我们可以很容易地看出为什么上述学生的预计最高贷款额为33,100 美元。也就是说,贷款额增加了:

- 每增加一岁,需支付 100 美元

- 每增加 1 美元收入就增加 10 美元

因此,就像决策树一样,我们可以查看该模型的参数并了解它如何进行预测。这是因为这些模型相对简单。决策树有几个节点,线性回归模型有 3 个参数。随着模型变得越来越复杂,我们不再能以这种方式理解它们。

Explainable 机器学习

您可以将 ML 模型视为一个函数。模型特征是输入,预测是输出。Explainable 模型是一种人类无法理解的复杂函数。这种模型的另一个名称是黑盒模型。我们需要一种额外的方法/技术才能窥视黑盒并了解模型的工作原理。

Explainable 模型需要额外的技术才能被人类理解

这种模型的一个例子是随机森林。随机森林由许多决策树组成。在做出最终预测时,会考虑所有单个树的预测。要了解随机森林的工作原理,我们必须同时了解所有单个树的工作原理。即使只有少量的树,人类也做不到这一点。

图片来源:Satya Mallick & Sunita Nayak

当我们开始研究神经网络等算法时,事情变得更加复杂。具体来说,用于图像识别的卷积神经网络 AlexNet3 有62,378,344 个参数 4。相比之下,我们上面的回归模型只有3 个参数。人类不可能仅通过查看参数权重来理解 AlexNet 之类的模型的工作原理。

用于理解 explainable 模型的技术

因此,我们需要一些额外的技术来理解这些算法的工作原理。这些包括为特定模型创建的方法。例如,DeepLIFT: https://github.com/kundajelab/deeplift 就是为解释神经网络而创建的。它们还包括可应用于任何模型的模型无关方法。这些方法包括 LIME:https://github.com/marcotcr/lime、SHAP: https://github.com/slundberg/shap、PDPs 和 ICE Plots。

请记住,即使有了这些技术,我们也无法像使用i nterpretable 模型那样确定模型的工作原理。这些技术只能提供模型如何进行预测的近似值。它们都有自己的假设和局限性。

这意味着在使用任何技术得出结论时都应保持一定程度的谨慎。如果可能,应结合使用多种技术。还应使用数据可视化和领域知识来验证结论。

Interpretability

到目前为止,我们已经讨论了模型是 interpretable 还是 explainable。然而,应用这个二元标志可能并不总是有意义的。模型的 Interpretability 是一个范围。如果一个模型比另一个模型更容易让人理解它的预测方式,那么这个模型就比另一个模型更容易解释。

Interpretability 是指模型能被人类理解的程度2

图 2给出了可解释性频谱。卷积神经网络的可解释性不如随机森林,而随机森林的可解释性又不如决策树。大多数模型通常可以归类为可解释或可解释的。然而,存在一个灰色区域,人们对此的分类意见不一。

定义问题

这个灰色区域是我们发现这个定义的第一个问题。我们可能同意,一个有 2 棵树的随机森林是可解释的。然而,一个有 100 棵树的随机森林是不可解释的。在什么时候(即有多少棵树),模型从 interpretable 变为 explainable ?即使是具有许多节点的决策树或具有许多参数的回归,如果没有额外的技术,也可能变得过于复杂,人类无法理解。

问题是我们试图根据人类的理解能力对模型进行分类。没有正式的方法来衡量这一点。你理解模型的能力取决于你的技术技能和专业经验。即使在专业人士中,也会有分歧。

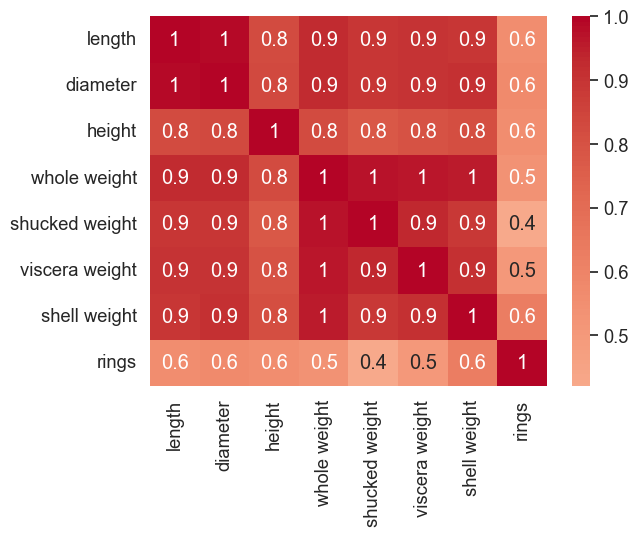

另一个问题是我们定义什么为附加技术。为了理解哪怕是最简单的模型,我们也会寻求其他方法的帮助。例如,在解释线性回归的权重时,通常使用相关矩阵。这是否意味着回归现在是一个 explainable 模型?

这就引出了一个问题:我们真的需要这个定义吗?IML 的目标是理解和解释我们的模型。我们不需要将它们归类为 interpretable 或 explainable。我们选择的方法最终将取决于模型的类型和我们寻求回答的具体问题。

参考

C. Rudin, Stop explaining black-box machine learning models for high stakes decisions and use interpretable models instead (2019), https://arxiv.org/abs/1811.10154 ↩︎

C. Molnar, Interpretable Machine Learning: A Guide for Making Black Box Models Explainable (2023), Chapter 3: Interpretability, https://christophm.github.io/interpretable-ml-book/taxonomy-of-interpretability-methods.html ↩︎ ↩︎

AlexNet, https://en.wikipedia.org/wiki/AlexNet ↩︎

S. Mallick & S. Nayak, Number of Parameters and Tensor Sizes in a Convolutional Neural Network (CNN) (2018), https://www.learnopencv.com/number-of-parameters-and-tensor-sizes-in-convolutional-neural-network/ ↩︎

![db期末复习自用[应试向 附习题]](https://i-blog.csdnimg.cn/direct/d32d8de596c449b6897aa0c03fae2aa5.png)